Jensen Huang, „Nvidia“ generalinis direktorius teigia, kad jo kompanijos dirbtinio intelekto (DI) lustų vystymosi sparta viršija teorinę, Moor’o dėsniu apibrėžtą.

Huang’as savo interviu „TechCrunch“ antradienį Las Vegase vykstančioje CES parodoje pasakė: „Mūsų sistemos vystosi gerokai greičiau nei Moor’o dėsnis teigia“.

„Intel“ bendraįkūrėjas Gordonas Moore’as 1965 metais prognozavo: tranzistorių skaičius puslaidininkių lustuose maždaug padvigubės kiekvienais metais, taip padvigubindamas ir jų našumą. Prognozė iš esmės pasitvirtino, dešimtmečius matant greitą našumo augimą ir kainų mažėjimą.

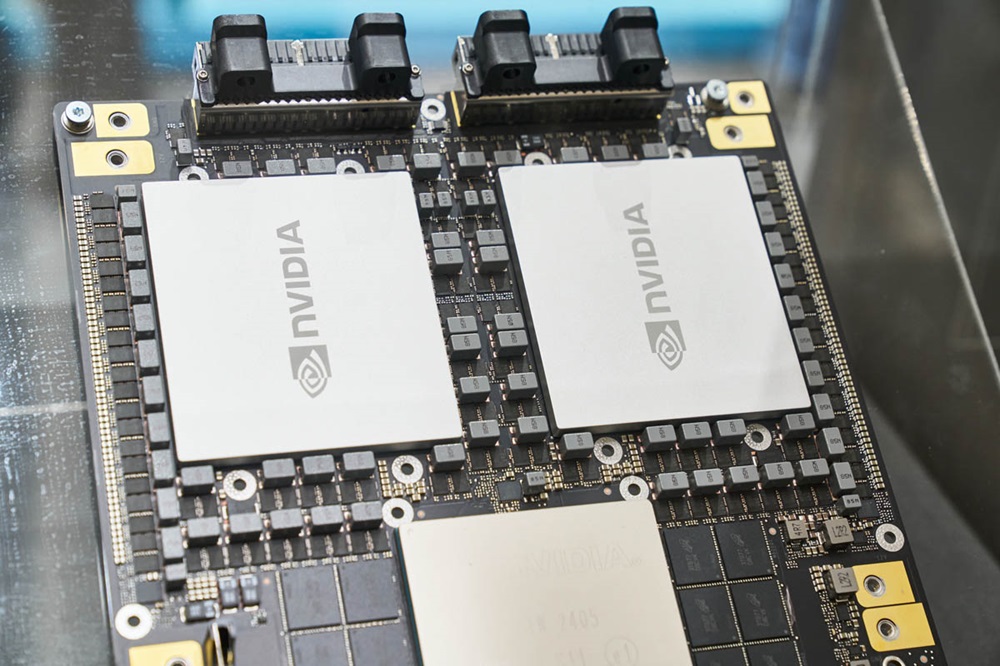

Pastaraisiais metais lustų vystymosi sparta sumažėjo. Nepaisant to, Huang’as teigia, kad „Nvidia“ DI lustų vystymasis dabar vyksta dar greičiau. Kompanija teigia, kad jos naujausias duomenų centro superlustas vykdant DI užduotis daugiau nei 30 kartų greitesnis nei praeitos kartos lustas.

Huang’as teigia: „Tuo pačiu metu mes galime kurti architektūrą, lustą, sistemą, bibliotekas ir algoritmus. Kuriant visumą, galima judėti greičiau nei teigia Moor’o dėsnis“.

Šis drąsus „Nvidia“ generalinio direktoriaus teiginys pasirodo metu, kai besidomintiems kyla klausimas – ar DI vystymasis nesustojo? Lyderiaujančios DI laboratorijos „OpenAI“, „Google“ ir „Anthropic“ naudoja „Nvidia“ DI lustus savo modelių apmokymui ir jų vykdymui. Pažanga šių lustų vystyme turėtų atsispindėti DI modelių galimybių augime.

Huang’as nesutinka su teiginiu, kad DI progresas lėtėja. Jis teigia, kad dabar yra trys DI modelių fazės: išankstinis apmokymas, pradinė apmokymo fazė, kai DI modeliai apmokomi iš didelio duomenų kiekio; apmokymas po pradinio etapo, kuris patikslina DI modelio atsakymus, naudojant žmogaus grįžtamąjį ryšį; apdorojimas testo metu, kuris vyksta inferencijos fazėje ir suteikia DI modeliui daugiau laiko pamąstyti po kiekvieno klausimo.

„Moore’o dėsnis kompiuterijos istorijoje buvo toks svarbus, nes jis mažino skaičiavimo kaštus“, – sakė Huang’as. „Tas pats nutiks ir su inferencija, kai mes didinsime našumą, o dėl to inferencijos kaštai mažės.“

„Nvidia“ „H100“ buvo geriausias pasirinkimas technologijų kompanijoms, siekiančioms apmokyti DI modelius. Tačiau dabar, kai kompanijos vis labiau orientuojasi į inferencijos fazę, kyla klausimų, ar brangūs „Nvidia“ lustai sugebės išlaikyti savo poziciją?

DI modeliai, naudojantys skaičiavimus testo metu, šiuo metu naudoti yra brangūs. Yra nerimaujama, kad „OpenAI o3“ DI modelis, naudojantis našesnį skaičiavimą testo metu, bus per brangus naudotojams. Kad pasiektų žmogaus lygio rezultatus bendrojo intelekto teste, „OpenAI“ vienai užduočiai išleido 20 JAV dolerių. Tuo tarpu „ChatGPT Plus“ prenumeratos kaina – 20 JAV dolerių per mėnesį.

„Nvidia“ generalinis direktorius Huang’as pirmadienį pademonstravo naujausią „Nvidia“ duomenų centro superlustą „GB200 NVL72“. Šis lustas vykdant DI inferencijos užduotis yra 30–40 kartų greitesnis nei anksčiau geriausiai parduodami „Nvidia“ lustai „H100“. Huang’as teigia, kad toks našumo šuolis reiškia, jog DI modeliai, tokie kaip „OpenAI o3“, reikalaujantys daug skaičiavimų inferencijos fazėje, laikui bėgant taps pigesni. Huang’o teigimu, pagrindinis dėmesys yra nukreiptas į našesnių lustų kūrimą, ilgainiui lemsiantį žemesnes jų kainas.

Per pastaruosius metus yra matomas DI modelių kainų sumažėjimas, pasiektas dėl tokių kompanijų kaip „Nvidia“ skaičiavimo proveržio. Huang’as teigia, kad tai tendencija, kurią jis tikisi tęsti.

Apibendrinant Huang’as teigia, kad „Nvidia“ naujausi DI lustai yra 1000 greitesni nei tie, kuriuos „Nvidia“ kūrė prieš 10 metų. Ir tai yra greitesnis tempas nei numatyta Moor’o dėsnyje. Huang’as nemano, kad pažanga artimiausiu metu sustos